Définition de l’Intelligence Artificielle

Pour ma part, je ne crains nullement ce que l’on appelle « l’Intelligence Artificielle » (IA). Depuis quelques années, on voit se développer sur internet et les réseaux sociaux, une nouvelle forme de diffusion de l’information écrit et visuelle. Cette diffusion fait appel aux nouvelles technologies fondées sur l’informatique. Rappelons pour commencer que l’IA est une branche de l’informatique. Celle qui permet aux systèmes d’apprendre et d’exécuter des tâches normalement associées à l’intelligence humaine. Comme la reconnaissance vocale, la prise de décisions ou la perception visuelle. Rappelons que dans les années 80, deux techniques importantes furent développées.

La première, le deep learning (DL), ou « apprentissage en profondeur », a permis aux ordinateurs d’apprendre par l’expérience. Le second, le « système expert » (SE), imite la capacité de l’être humain à prendre des décisions. Les ordinateurs ont commencé à utiliser un raisonnement fondé sur des « règles » en recourant principalement à une structure « si… alors » mise en œuvre pour répondre à des questions binaires. Ici, la réponse est soit oui, soit non. Depuis les années 2000, trois améliorations ont été apportées :

1. Développement des unités de traitement graphique (GPU) sans lesquelles une IA serait non crédible, provoquant juste un simple haussement d’épaules.

2. Exploitation de l’énorme quantité d’informations mémorisées (Le « Big Data ») depuis qu’internet existe (BD).

3. Développement de nouveaux algorithmes utilisant des variables cachées qui permettent de trier et d’optimiser les résultats d’un calcul.

Variables cachées

En réalité, les points #1 et #2 sont assez triviaux et de nature purement technologique. Ils n’expliquent pas le développement fulgurant observé dans le domaine de l’IA ces dernières années. Ce qui est crucial, c’est le point #3 sur lequel il convient d’être plus bavard :

Car, la description « accessible » que l’on a d’un système, est très souvent la liste de ses comportements observables. Une telle liste est très habituellement une fonction de variables qui ne sont pas immédiatement évidentes. On parle alors de variables dites « cachées » ou bien encore « latentes ». Et, ces variables « cachées » mais hautement pertinentes, sont beaucoup moins nombreuses que les variables observées qui nous sont directement accessibles. D’où le développement de nouveaux algorithmes dont le but n’est pas de traiter directement les observables accessibles. Mais, plutôt, de réduire l’espace des données disponibles à quelques variables cachées. Variables qui sont peu nombreuses, et qui décrivent au mieux les données brutes disponibles.

Analyse en Composantes Principales (ACP)

L’outil clé est ici l’analyse en composantes principales (ACP ou PCA en anglais pour principal component analysis). Cette analyse consiste à transformer des variables dites « corrélées » sur un plan statistique, en nouvelles variables décorrélées les unes des autres. Ces nouvelles variables se nomment « composantes principales » ou axes principaux. L’ACP permet donc de résumer l’information énorme disponible avec de nombreuses variables corrélées en un petit nombre de variables indépendantes les unes des autres. D’un point de vue mathématique, selon le domaine d’application, on utilise soit la transformation de Karhunen–Loève (KLT), soit la transformation de Hotelling (HT).

Les champs d’application de l’ACP sont aujourd’hui multiples, allant de la biologie à la recherche économique et sociale, et plus récemment le traitement d’images et l’apprentissage automatique. L’utilité de l’ACP réside dans les points suivants :

Description et visualisation des données complexes.

Décorrélation des données brutes, la nouvelle base étant constituée d’axes non corrélés entre eux.

Minimisation du bruit, en considérant que les axes que l’on décide d’oublier sont des axes bruités.

Effectuer une réduction de dimension des données d’entraînement en apprentissage automatique.

Il s’agit d’une approche aussi bien géométrique que statistique. Géométrique, puisque les variables se représentent dans un nouvel espace, selon des directions d’inertie maximale. Statistique, parce que la recherche porte sur des axes indépendants expliquant au mieux la variabilité — la variance — des données. En résumé, lorsqu’il s’agit de compresser un ensemble de variables aléatoires, les premiers axes de l’ACP constituent un meilleur choix, aussi bien du point de vue de l’inertie géométrique que depuis la perspective de la variance statistique.

Insuffisance du ternaire GPU/BD/ACP

Après cette démystification de ce qui se cache derrière une IA, se pose l’inévitable question de savoir si la notion « d’intelligence » est réductible à ce ternaire (GPU/BD/ACP). Pour ce qui me concerne, la réponse à cette question est un « non », franc et massif. Et, pour bien enfoncer le clou, voici quelques éléments de réflexion.

Pour fonctionner, une IA a besoin d’accéder à une base de données de type Big Data (BD), la plus large possible. Le gros problème qu’elle rencontre ici est que pour accéder aux données, il lui faut disposer d’une source d’alimentation électrique. Débranchez l’IA du secteur, ou bien, retirez-lui sa batterie et il n’y a plus rien, de manière instantanée. Toutefois, dès que vous remettez une source d’énergie, le système redémarre et redevient totalement opérationnel.

Pour un être humain, ce débranchement instantané est impossible. Si vous le privez de nourriture, il pourra continuer à fonctionner pendant des années tant qu’il aura de l’eau à sa disposition. Évidemment, si vous lui supprimez l’eau, il finira par mourir au bout de quelques jours. Mais, en aucun cas, la perte d’activité sera instantanée comme avec une intelligence artificielle. Et, une fois l’être humain mort, impossible de redevenir opérationnel si la nourriture et l’eau redeviennent disponibles. Ces simples considérations d’alimentation, nous font toucher du doigt que si le cerveau est parfaitement capable d’utiliser le triangle GPU/BD/ACP, il ne peut pas être réduit à cela. Il y a un plus, qui dépasse le strict cadre informatique.

Et, la Conscience ?

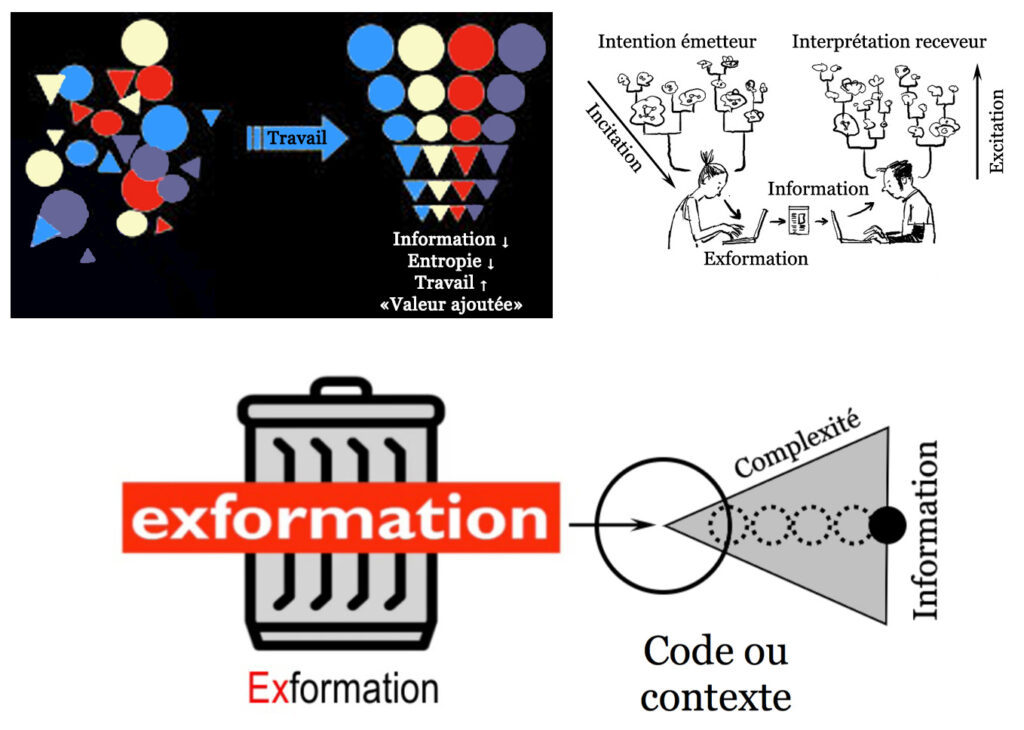

Ce truc est, bien sûr, ce que l’on appelle la « conscience ». Et, comme il est facile de le démontrer (voir https://riviste.fupress.net/index.php/subs/article/view/161), cette conscience est aussi bien neuronale (le moi vu de l’extérieur) qu’extra-neuronale (le moi-même vu de l’intérieur). Rappelons que si le moi traite l’information transmise à l’extérieur du système, le moi-même traite pour sa part l’exformation, c’est-à-dire le contexte, qui lui reste piégé à l’intérieur du système n’étant jamais transmis (voir ici pour en savoir plus : https://marchenry.org/product/de-linformation-a-lexformation/). Pour faire plus simple, un cerveau humain traite l’information aussi bien de manière digitale via les neurones (GPU/BD/ACP) que de manière intuitive via l’eau d’hydratation de ces mêmes neurones. Bref, tant qu’une IA n’utilisera pas l’eau, elle restera largement en deçà d’une intelligence biologique (IB), bactérienne, végétale, animale ou humaine. Car, la fonction « intuition » utilise l’eau, interface de communication instantanée et non locale avec le vide quantique, appelé aussi « éther ».

Intelligence Biologique

Un dernier point concerne la notion même d’intelligence. Si l’on y réfléchit un tant soit peu, pas besoin d’être intelligent pour prendre des décisions lorsque l’on dispose d’une base de données gigantesque. Bien au contraire. On reconnaît l’intelligence quand on est capable de prendre la bonne décision avec un minimum d’information à sa disposition. L’IA, telle qu’on la connaît de nos jours, n’est donc en rien « intelligente ». Car, si l’on réduit la taille de la BD à un contenu minimal, plus rien ne sort. Avec des êtres humains, c’est totalement différent. Certains d’entre eux, appelés « génies » sont capables de faire des merveilles, voire des miracles, avec trois fois rien comme données. La raison en est simple, et l’on retrouve ici la possibilité de décider par intuition, et non par raisonnement.

Conclusion

On peut hautement être impressionné par les performances actuelles de l’intelligence artificielle. Mais, qu’il soit bien clair qu’il s’agit ici de performance technologique sous réserve d’un accès sans limites à l’électricité. Rien n’empêche de rêver à un monde dans lequel les machines remplaceraient les êtres biologiques fonctionnant à l’eau. Mais, un tel monde serait extrêmement peu efficace et d’une viabilité nulle à long terme.

Plutôt que de parler d’intelligence artificielle, on ferait peut-être mieux de parler de machines expertes dans le traitement de l’information. Car, on peut exceller dans la collecte et l’analyse d’un maximum d’information, tout en étant un parfait idiot sur le plan de la créativité. La folie actuelle autour de tous ces robots hyper-efficaces, ne pourra pas durer éternellement. Alors que la vie biologique, bactérienne ou cellulaire, existe depuis des milliards d’années. Par conséquent, s’il y a lieu d’être inquiets pour l’avenir, c’est plutôt face aux manipulations génétiques ou à la pollution toujours croissante de l’eau.

Leave a Reply